OpenAI представила нові голосові моделі ChatGPT з розширеними можливостями налаштування мовлення

У компанії зазначають, що нові моделі базуються на "передових алгоритмах машинного навчання"

Розробник ChatGPT, компанія OpenAI, оголосила про випуск голосових моделей нового покоління, які значно розширюють можливості перетворення тексту на мову та навпаки. У компанії зазначають, що нові моделі базуються на "передових алгоритмах машинного навчання".

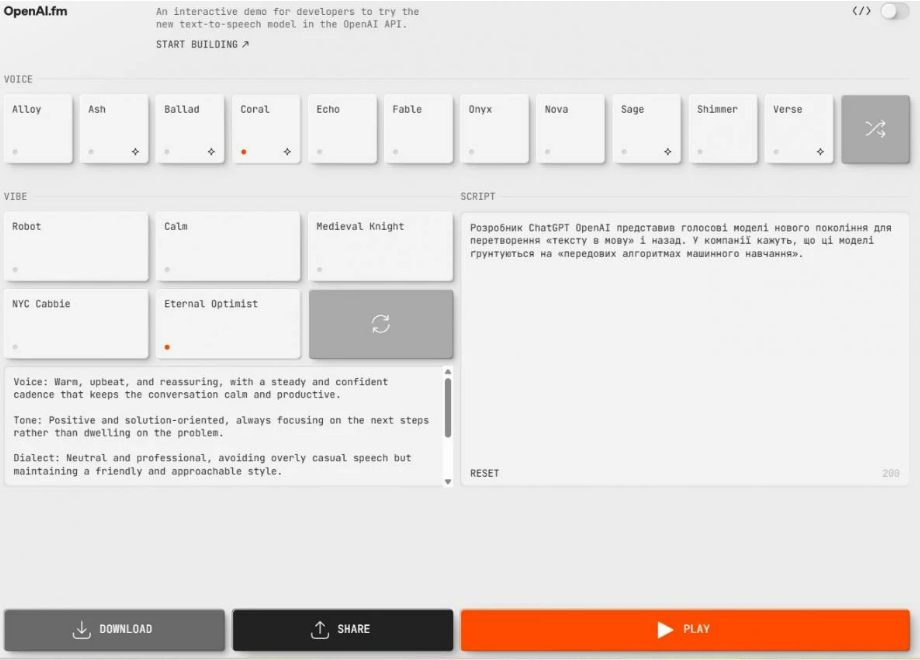

Ключовою особливістю нових розробок є можливість не лише конвертувати текст у мову, але й детально налаштовувати характеристики озвучення. Користувачі зможуть змінювати голос, його стиль, тембр та емоційне забарвлення. Наприклад, з'явилася можливість згенерувати мовлення "як у пірата" або як у оповідача дитячих казок. Окрім готових пресетів, передбачена можливість ручного введення інструкцій для досягнення бажаного звучання, пише TechCrunch.

Паралельно з цим, OpenAI значно поліпшила технологію розпізнавання мови. Нові моделі gpt-4o-transcribe та gpt-4o-mini-transcribe демонструють значно меншу кількість помилок при транскрибуванні мовлення у текст, навіть у складних акустичних умовах, таких як сильний акцент, шум та різна швидкість мовлення.

Розробка нових голосових моделей спрямована на підвищення інтуїтивності взаємодії зі штучним інтелектом, наближаючи її до природного спілкування. Оновлені технології можуть бути легко інтегровані в різноманітні додатки та сервіси.

Нові моделі вже доступні для розробників через API. Крім того, усі охочі можуть протестувати їхні можливості на спеціальному вебсайті OpenAI.

Раніше повідомлялося про плани OpenAI щодо введення платної підписки на найпотужніші та найпередовіші моделі ШІ, вартість якої може сягати до 1 мільйона гривень на місяць. Ці моделі будуть орієнтовані на підтримку "досліджень рівня доктора наук".

У майбутньому OpenAI планує випустити ще більш революційну модель GPT-5, яка, за очікуваннями, зможе вивчати будь-які завдання, які зможуть придумати люди, що зробить її практично невідмінною від людського інтелекту у багатьох сферах.